- Microsoft menemukan Whisper Leak menunjukkan kelemahan privasi di dalam sistem AI terenkripsi

- Obrolan AI terenkripsi mungkin masih membocorkan petunjuk tentang apa yang didiskusikan pengguna

- Penyerang dapat melacak topik percakapan menggunakan ukuran dan waktu paket

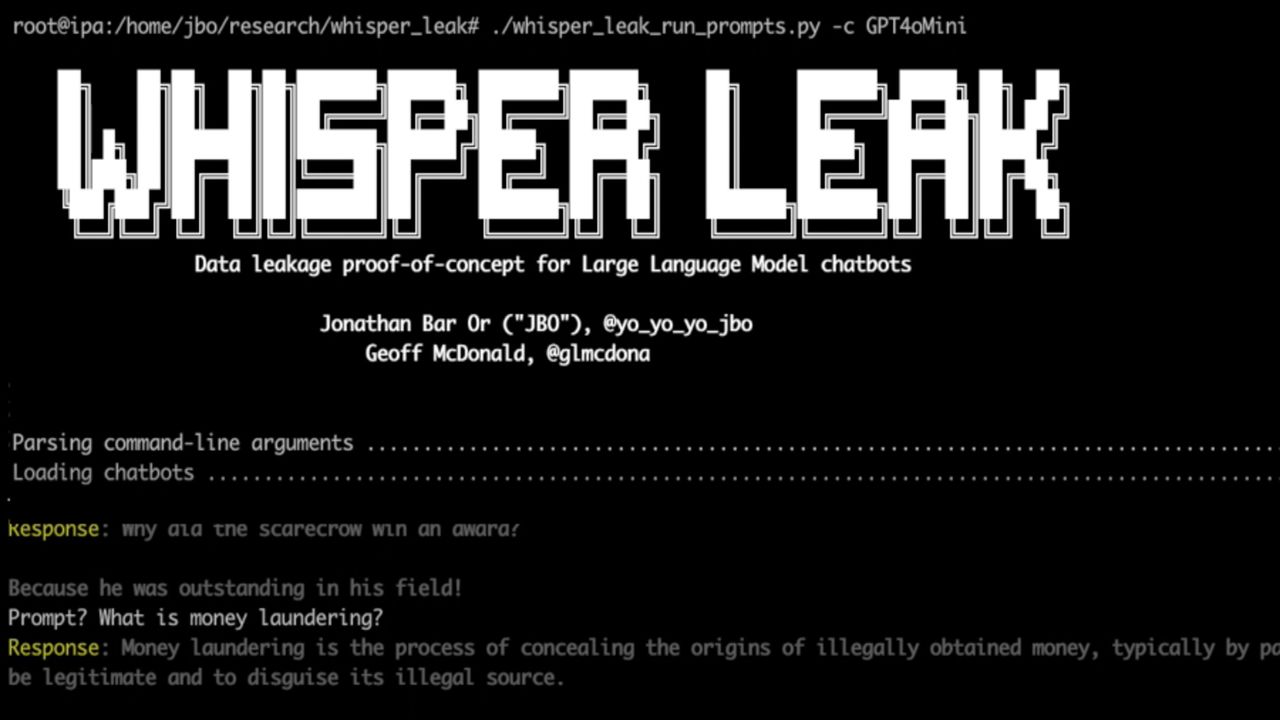

Microsoft telah mengungkapkan jenis serangan siber baru yang disebut “Whisper Leak”, yang mampu mengekspos topik yang didiskusikan pengguna dengan chatbot AI, bahkan ketika percakapan dienkripsi sepenuhnya.

Perusahaan riset menyarankan penyerang dapat mempelajari ukuran dan waktu pertukaran paket terenkripsi antara pengguna dan model bahasa besar untuk menyimpulkan apa yang sedang dibahas.

“Jika lembaga pemerintah atau penyedia layanan internet memantau lalu lintas ke AI yang populer chatbotmereka dapat mengidentifikasi pengguna yang mengajukan pertanyaan tentang topik sensitif tertentu dengan andal,” kata Microsoft.

Serangan Kebocoran Bisikan

Artinya “terenkripsi” bukan berarti tidak terlihat – kerentanannya terletak pada caranya LLM mengirim tanggapan.

Model ini tidak menunggu balasan lengkap, namun mengirimkan data secara bertahap, menciptakan pola kecil yang dapat dianalisis oleh penyerang.

Seiring waktu, ketika mereka mengumpulkan lebih banyak sampel, pola-pola ini menjadi lebih jelas, sehingga memungkinkan tebakan yang lebih akurat tentang sifat percakapan.

Teknik ini tidak mendekripsi pesan secara langsung namun memaparkan metadata yang cukup untuk membuat kesimpulan yang tepat, yang bisa dibilang juga mengkhawatirkan.

Setelah pengungkapan Microsoft, OpenAI, Mistral, dan xAI menyatakan bahwa mereka bergerak cepat untuk menerapkan mitigasi.

Salah satu solusi menambahkan, “urutan teks acak dengan panjang variabel” ke setiap respons, sehingga mengganggu konsistensi ukuran token yang diandalkan penyerang.

Namun, Microsoft menyarankan pengguna untuk menghindari diskusi sensitif melalui Wi-Fi publik, menggunakan VPN, atau tetap menggunakan model LLM non-streaming.

Temuan ini muncul bersamaan dengan pengujian baru yang menunjukkan bahwa beberapa LLM open-weight tetap rentan terhadap manipulasi, terutama selama percakapan multi-turn.

Para peneliti dari Cisco AI Defense menemukan bahkan model yang dibuat oleh perusahaan-perusahaan besar kesulitan mempertahankan kontrol keselamatan ketika dialog menjadi rumit.

Beberapa model, kata mereka, menunjukkan “ketidakmampuan sistemis… untuk mempertahankan batasan keselamatan dalam interaksi jangka panjang.”

Pada tahun 2024, muncul laporan bahwa an Chatbot AI membocorkan lebih dari 300.000 file berisi informasi identitas pribadi, dan ratusan Server LLM dibiarkan terbukamenimbulkan pertanyaan tentang seberapa aman sebenarnya platform obrolan AI.

Pertahanan tradisional, seperti perangkat lunak antivirus atau perlindungan firewall, tidak dapat mendeteksi atau memblokir kebocoran saluran samping seperti Whisper Leak, dan penemuan ini menunjukkan hal tersebut alat AI dapat secara tidak sengaja memperluas paparan terhadap pengawasan dan inferensi data.

Perlindungan pencurian ID terbaik untuk semua anggaran

Ikuti TechRadar di Google Berita Dan tambahkan kami sebagai sumber pilihan untuk mendapatkan berita, ulasan, dan opini pakar kami di feed Anda. Pastikan untuk mengklik tombol Ikuti!

Dan tentu saja Anda juga bisa Ikuti TechRadar di TikTok untuk berita, review, unboxing dalam bentuk video, dan dapatkan update rutin dari kami Ada apa juga.