- Nvidia Rubin DGX SuperPOD menghadirkan 28,8 Exaflops hanya dengan 576 GPU

- Setiap sistem NVL72 menggabungkan 36 CPU Vera, 72 GPU Rubin, dan 18 DPU

- Throughput agregat NVLink mencapai 260TB/dtk per rak DGX untuk efisiensi

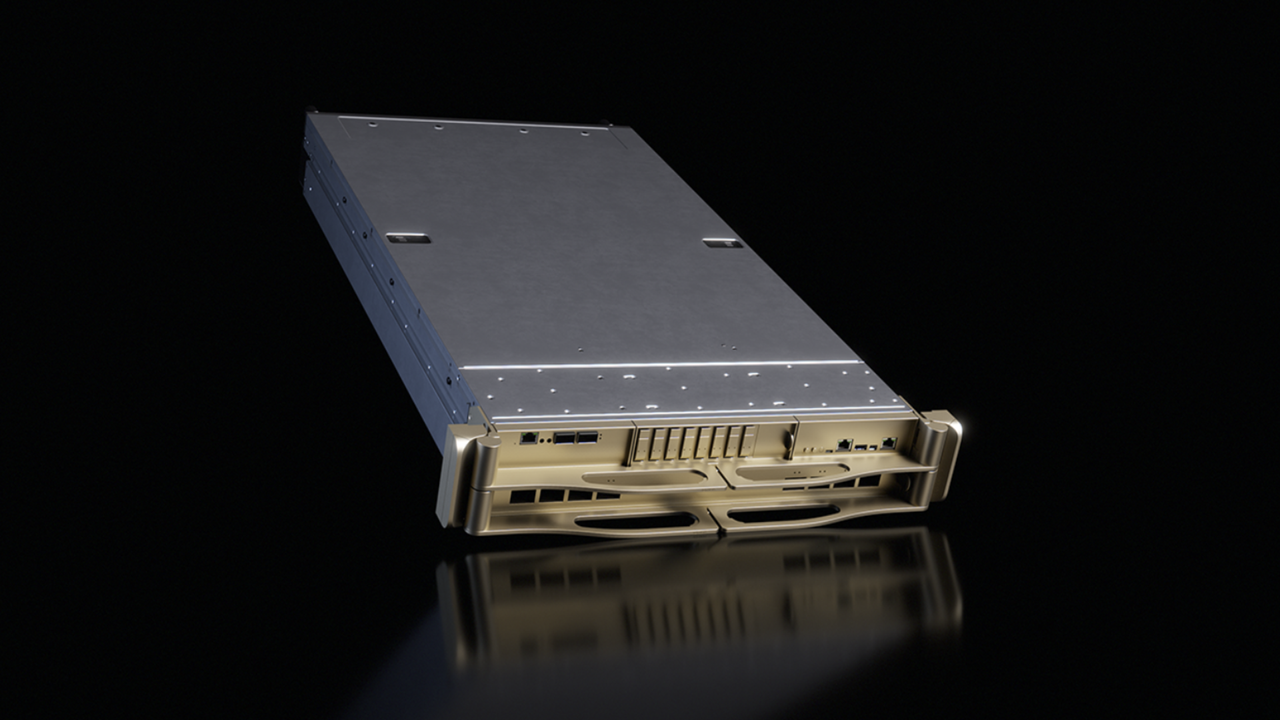

Pada CES 2026, Nvidia meluncurkan DGX SuperPOD generasi berikutnya yang didukung oleh platform Rubin, sebuah sistem yang dirancang untuk menghadirkan komputasi AI ekstrem dalam rak yang padat dan terintegrasi.

Menurut perusahaanSuperPOD mengintegrasikan beberapa sistem Vera Rubin NVL72 atau NVL8 ke dalam satu mesin AI yang koheren, mendukung beban kerja skala besar dengan kompleksitas infrastruktur minimal.

Dengan modul berpendingin cairan, interkoneksi berkecepatan tinggi, dan memori terpadu, sistem ini menargetkan institusi yang mencari throughput AI maksimum dan mengurangi latensi.

Arsitektur komputasi berbasis Rubin

Setiap sistem DGX Vera Rubin NVL72 mencakup 36 Vera CPU72 GPU Rubin, dan 18 DPU BlueField 4, menghadirkan kinerja FP4 gabungan sebesar 50 petaflops per sistem.

Throughput agregat NVLink mencapai 260 TB/dtk per rak, memungkinkan memori penuh dan ruang komputasi untuk beroperasi sebagai satu mesin AI yang koheren.

Rubin GPU menggabungkan Mesin Transformer generasi ketiga dan kompresi yang dipercepat perangkat keras, memungkinkan beban kerja inferensi dan pelatihan diproses secara efisien dalam skala besar.

Konektivitas diperkuat oleh switch Ethernet Spectrum-6, InfiniBand Quantum-X800, dan SuperNIC ConnectX-9, yang mendukung transfer data AI berkecepatan tinggi deterministik.

Desain SuperPOD Nvidia menekankan kinerja jaringan ujung ke ujung, memastikan kemacetan minimal di cluster AI yang besar.

Quantum-X800 InfiniBand menghadirkan latensi rendah dan throughput tinggi, sementara Spectrum-X Ethernet menangani lalu lintas AI timur-barat secara efisien.

Setiap rak DGX dilengkapi memori cepat 600TB, penyimpanan NVMe, dan memori konteks AI terintegrasi untuk mendukung pipeline pelatihan dan inferensi.

Platform Rubin juga mengintegrasikan orkestrasi perangkat lunak tingkat lanjut melalui Nvidia Mission Control, menyederhanakan operasi cluster, pemulihan otomatis, dan manajemen infrastruktur untuk pabrik AI besar.

DGX SuperPOD dengan 576 GPU Rubin dapat mencapai 28,8 Exaflops FP4, sementara sistem NVL8 individual menghasilkan FP4 FLOPS 5,5x lebih tinggi dibandingkan arsitektur Blackwell sebelumnya.

Sebagai perbandingan, Atlas 950 SuperPod dari Huawei mengklaim 16 Exaflops FP4 per SuperPod, yang berarti Nvidia mencapai efisiensi lebih tinggi per GPU dan memerlukan lebih sedikit unit untuk mencapai tingkat komputasi ekstrem.

Cluster DGX berbasis Rubin juga menggunakan lebih sedikit node dan kabinet dibandingkan SuperCluster Huawei, yang berskala hingga ribuan NPU dan memori beberapa petabyte.

Kepadatan kinerja ini memungkinkan Nvidia untuk bersaing secara langsung dengan proyeksi output komputasi Huawei sekaligus membatasi ruang, daya, dan overhead interkoneksi.

Platform Rubin menyatukan komputasi AI, jaringan, dan perangkat lunak ke dalam satu tumpukan.

Perangkat lunak Nvidia AI Enterprise, layanan mikro NIM, dan orkestrasi misi penting menciptakan lingkungan yang kohesif untuk penalaran konteks panjang, AI agen, dan penerapan model multimodal.

Meskipun Huawei melakukan penskalaan terutama melalui jumlah perangkat keras, Nvidia menekankan efisiensi tingkat rak dan kontrol perangkat lunak yang terintegrasi erat, yang dapat mengurangi biaya operasional untuk beban kerja AI skala industri.

TechRadar akan meliput secara ekstensif tahun ini CESdan akan menyampaikan kepada Anda semua pengumuman penting yang terjadi. Kunjungi kami Berita CES 2026 halaman untuk berita terbaru dan penilaian langsung kami tentang segala hal mulai dari TV nirkabel dan layar lipat hingga ponsel baru, laptop, gadget rumah pintar, dan AI terbaru. Anda juga dapat mengajukan pertanyaan kepada kami tentang pertunjukan di kami Tanya Jawab langsung CES 2026 dan kami akan melakukan yang terbaik untuk menjawabnya.

Dan jangan lupa ikuti kami di TikTok Dan Ada apa untuk yang terbaru dari lantai pertunjukan CES!