Perangkat keras akselerasi AI menjadi semakin mahal, karena chip generasi berikutnya menuntut anggaran daya yang tinggi dan investasi infrastruktur yang besar. Bagi banyak startup dan perusahaan kecil, biaya dan kompleksitas penerapan AI dalam skala besar menciptakan hambatan jauh sebelum pengembangan perangkat lunak dimulai.

Pemain silikon baru seperti FuriosaAI mencoba memikirkan kembali persamaan tersebut, dengan fokus pada efisiensi, kinerja, dan pendekatan alternatif terhadap pasar yang didominasi GPU.

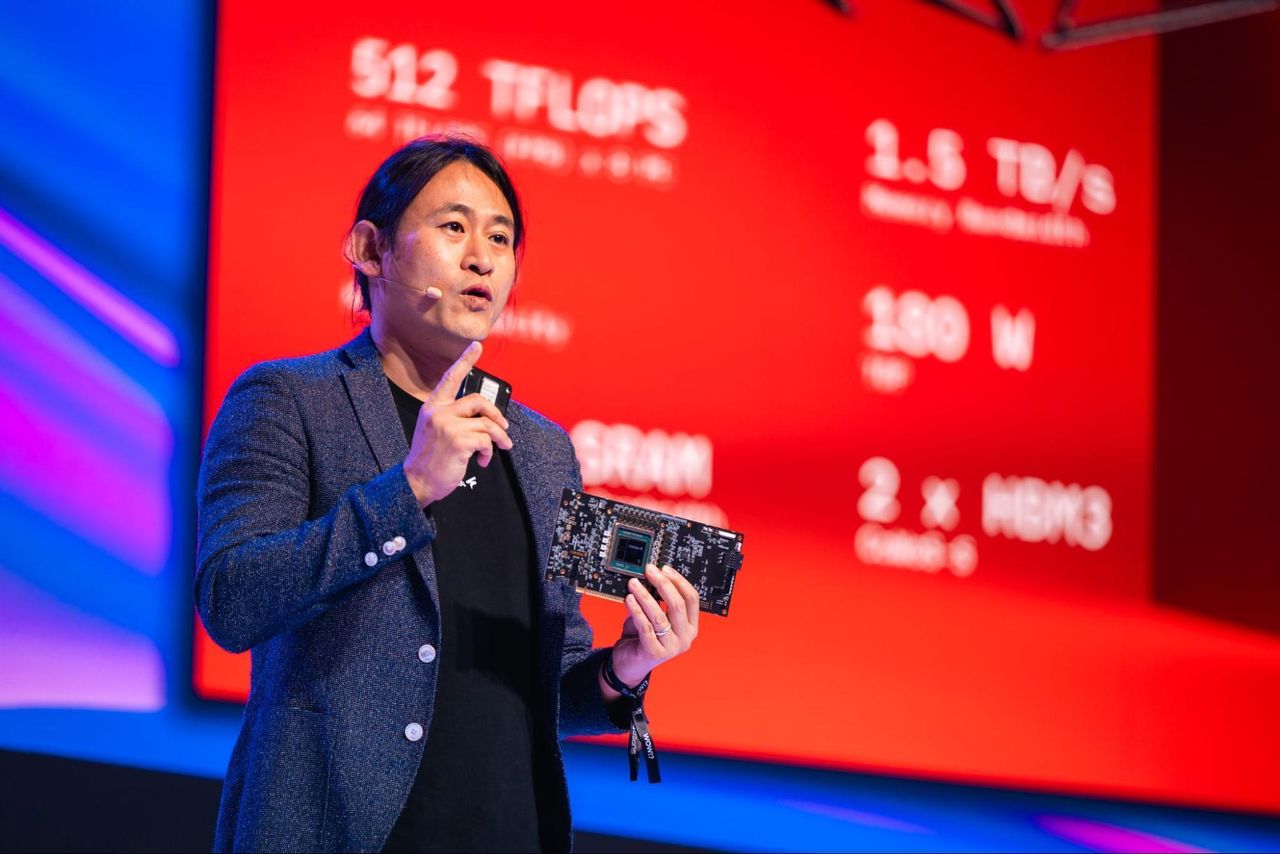

Didirikan di Korea Selatan, FuriosaAI mengembangkan chip inferensi AI yang dirancang untuk memberikan kinerja tinggi sekaligus mengurangi konsumsi daya dan beban pusat data. Prosesor terbarunya, RNGD, dibangun berdasarkan arsitektur Prosesor Kontraksi Tensor milik perusahaan dan bertujuan untuk menjalankan model AI yang menuntut tanpa bergantung pada kerangka kerja GPU tradisional.

- Secara historis, Jepang dan Eropa melahirkan beberapa perusahaan hebat (ST Electronics, NEC, dll.). Mengapa hanya ada sedikit pemain silikon AI di luar Tiongkok dan AS?

Pertama, saya akan menantang premis Anda, setidaknya sedikit: Sangat sedikit startup perangkat keras di mana pun yang mampu melawan dominasi Nvidia dalam AI. Bahkan satu setengah dekade setelah AlexNet, kita masih berada di tahap awal industri ini. Dan beberapa inovator perangkat keras AI, seperti Hailo dan Axelera, sebenarnya juga muncul di luar AS atau Tiongkok.

Namun daftar ini pendek karena alasan struktural.

Tidak seperti penambangan kripto, yang algoritmanya tetap dan ASIC sederhana bekerja dengan baik, AI maju dan berkembang pesat.

Membangun sebuah chip untuk target bergerak memerlukan keahlian perangkat keras dan kompiler, yang cenderung berkumpul di tempat-tempat dengan warisan semikonduktor yang kuat. Hanya ada sedikit tempat di dunia yang memiliki hubungan mendalam dengan mitra pabrikan dan produsen chip.

Inilah mengapa berbasis di Korea Selatan sebenarnya merupakan keunggulan kompetitif bagi Furiosa.

Kami memiliki akses terhadap talenta dari program teknik kelas dunia di universitas-universitas Korea dan raksasa teknologi Korea. Kami juga dapat mengembangkan kemitraan dengan perusahaan terkemuka di Korea (seperti SK Hynix yang menyediakan HBM3 untuk chip inferensi chip generasi kedua kami, RNGD) dan negara lain di Asia (seperti mitra pengecoran kami, TSMC, di Taiwan).

Jarak dari Silicon Valley juga memaksa kami mengambil pendekatan yang sangat disiplin. Furiosa diluncurkan hanya dengan pendanaan awal sebesar $1 juta USD dan kami menghabiskan beberapa tahun menyempurnakan ide kami sebelum mengirimkan silikon.

Kami berkomitmen penuh terhadap pendekatan berbasis kontraksi tensor dan mampu mengabaikan kebijaksanaan konvensional dan hype di Valley.

Namun perangkat keras harus bersaing di pasar global; kita tidak bisa hanya menjadi penyedia regional. Kini setelah kami mengirimkan RNGD dalam jumlah besar, kami bekerja sama dengan pelanggan perusahaan di seluruh dunia.

- Perangkat keras hanyalah bagian dari persamaan dan Nvidia membutuhkan waktu bertahun-tahun untuk membangun parit perangkat lunak (CUDA) yang sekarang terkenal itu. Apa yang dilakukan Furiosa untuk bersaing dengan musuh tangguhnya?

Mencoba mereplikasi perpustakaan CUDA Nvidia yang sangat besar adalah jalan buntu yang strategis.

Kami mengambil jalur yang lebih berani dengan merancang bersama perangkat keras dan perangkat lunak kami dari prinsip pertama khusus untuk AI, sehingga kami tidak perlu membuat ulang CUDA.

Chip kami menggunakan arsitektur Tensor Contraction Processor (TCP) milik Furiosa, yang secara asli mengeksekusi matematika multidimensi pembelajaran mendalam alih-alih memaksakannya ke dalam struktur lama yang digunakan oleh GPU.

Hal ini memungkinkan kompiler kami mengoptimalkan model tanpa memerlukan ribuan kernel yang disetel secara manual.

RNGD, yang kini diproduksi massal, menunjukkan keunggulan pendekatan kami. Teknologi ini memberikan inferensi berperforma tinggi untuk model paling menuntut di dunia dengan hanya mengonsumsi 180 watt (dibandingkan dengan 600 watt atau lebih yang dibutuhkan oleh GPU).

Mitra global seperti LG AI Research telah memverifikasi terobosan efisiensi dalam produksi ini.

Kami juga telah memecahkan penguncian CUDA dengan membangun tumpukan perangkat lunak kami untuk berintegrasi secara lancar dengan alat standar seperti PyTorch dan vLLM sehingga pengembang dapat mengakses kinerja ini tanpa mengubah alur kerja mereka.

- Perlahan-lahan perusahaan hyperscaler terbesar membangun solusi chip AI mereka sendiri (Google, Microsoft, Amazon) untuk mengurangi ketergantungan mereka pada pihak ketiga. Di manakah posisi Furiosa (dan lainnya) dalam gambaran itu?

Paradigma GPU saat ini menciptakan tantangan energi yang ekstrim dan hambatan infrastruktur bagi seluruh industri, termasuk hyperscaler. Kami melihat masa depan ditentukan oleh komputasi heterogen, di mana berbagai arsitektur bekerja berdampingan untuk melayani berbagai kebutuhan yang berbeda (seperti pelatihan vs. inferensi) dengan paling efektif.

Karena kami memprioritaskan TCO, efisiensi daya, dan fleksibilitas, teknologi kami akan memainkan peran penting dalam memecahkan masalah ini bagi semua orang.

Fokus kami saat ini adalah pada empat sektor tertentu yang paling merasakan dampak buruk listrik dan infra:

● Negara-negara dan industri yang diatur harus bekerja dengan data sensitif di lokasi mereka, bukan di cloud publik. RNGD memungkinkan mereka menerapkan inferensi berperforma tinggi dalam rangkaian daya yang ada, memastikan kedaulatan data tanpa memerlukan proyek infrastruktur baru yang besar.

● Bagi pelanggan perusahaan, TCO dan fleksibilitas adalah rajanya. RNGD cocok dengan rak standar berpendingin udara 15kW dan menghindari retrofit pendingin cair mahal yang diperlukan oleh GPU lama, menjadikannya cara penskalaan tercepat dan paling hemat biaya.

● Cloud regional dan terspesialisasi harus bersaing dengan 3 Besar dalam hal margin. Kepadatan komputasi RNGD yang tinggi memungkinkan CSP memaksimalkan pendapatan per rak sekaligus menjaga OpEx tetap rendah.

● Sektor lain, seperti perusahaan telekomunikasi, bekerja dengan lingkungan pusat data dengan daya terbatas di tepi jaringan. Efisiensi daya RNGD juga memenuhi kebutuhan mereka.

Chip generasi berikutnya kami, yang saat ini sedang dikembangkan, akan menargetkan hyperscaler secara langsung di samping sektor-sektor utama ini.

- Bagaimana Anda melihat masa depan pusat data berkembang (Anda mengunjungi pusat data pada tahun 2036, apa yang Anda lihat di dalamnya)?

Dalam 10 tahun mendatang, “pusat data” akan mempunyai arti yang berbeda-beda, seperti halnya “komputer” yang merujuk pada segala sesuatu mulai dari jam tangan pintar hingga server berkinerja tinggi.

Beberapa pusat data akan memiliki pengaturan futuristik yang Anda bayangkan: sangat besar dan (mungkin) bertenaga fusi atau mengorbit Bumi. Namun yang lain akan berukuran kecil dan sangat efisien.

Misalnya, rumah sakit setempat Anda akan memiliki pusat data AI lokal untuk menjalankan asisten cerdas bagi dokter dan perawat, menjaga latensi tetap rendah dan data tetap lokal dan aman.

Perusahaan telekomunikasi akan memiliki banyak pusat data AI “edge” berkinerja tinggi yang dioptimalkan untuk latensi sangat rendah.

Satu hal yang saya yakini adalah pusat data AI pada tahun 2036 tidak akan diisi dengan GPU. Ini akan menjadi berbagai silikon khusus AI untuk kebutuhan berbeda.

Hal ini sebagian disebabkan oleh inefisiensi daya GPU. Namun pada dasarnya ada kesepakatan luas bahwa arsitektur GPU tidak ideal untuk AI.

Pembuat GPU telah berupaya menjembatani kesenjangan tersebut dengan inovasi seperti menambahkan inti tensor ke chip mereka, namun pada akhirnya manfaat peralihan dari GPU ke arsitektur yang mengutamakan AI akan terlalu besar untuk diabaikan.

- Tanpa memberikan terlalu banyak detail untuk peta jalan Anda, akankah silikon Furiosa mengikuti jalur tradisional produk AI?

Fokus kami saat ini dan produk masa depan adalah memberikan apa yang paling dibutuhkan pelanggan perusahaan: inferensi pusat data berkinerja tinggi yang juga hemat daya, hemat biaya, dan mudah diterapkan tanpa peningkatan infrastruktur besar-besaran.

Hal ini berarti memprioritaskan metrik seperti token per watt dan token per rak untuk kepadatan komputasi yang lebih besar.

Kami juga akan secara agresif memanfaatkan kemajuan industri baru, seperti node yang lebih kecil dan teknologi memori baru.

Chip generasi pertama kami menggunakan node 14 nanometer. Chip RNGD kami menggunakan HBM3 dan node 5 nanometer dan kami akan terus mengembangkannya. Namun inovasi arsitektur kamilah yang memungkinkan kami mencapai kinerja yang lebih baik dan lebih hemat energi dibandingkan GPU yang dibangun pada node yang sama.

Satu hal lagi yang perlu diperhatikan tentang peta jalan kami adalah bahwa ini adalah tentang perangkat lunak dan perangkat keras. Furiosa memiliki lebih banyak insinyur perangkat lunak daripada insinyur perangkat keras karena kami harus terus mendukung model baru dan alat penerapan dengan cepat dan efektif.

Kami merilis tiga pembaruan SDK utama pada tahun 2025 dan akan mempertahankan kecepatan tersebut pada tahun 2026 dan seterusnya.

- Furiosa berasal dari Korea Selatan. Bagaimana para chaebol besar (Samsung, LG, Hyundai, SK Hynix) memandang startup ini? Kemitraan apa yang ada saat ini?

Kami telah bekerja sama dengan para pemimpin teknologi besar Korea sebagai mitra dan pelanggan: Samsung Foundry memproduksi chip generasi pertama kami, SK Hynix memasok memori HBM3 untuk RNGD, dan LG adalah pelanggan perusahaan andalan yang saat ini menggunakan silikon kami. Ini adalah hubungan mendalam yang terjalin selama bertahun-tahun.

Selain konglomerat, kami bekerja sama dengan perusahaan rintisan AI yang berbasis di Korea dan kompetitif secara global seperti Upstage, dan kami mendapatkan manfaat dari konsumen Korea yang paham AI dan basis industri besar di bidang otomotif, pembuatan kapal, dan sektor lainnya.

AI juga merupakan prioritas kebijakan utama pemerintah Korea. Presiden Korea telah menetapkan inisiatif ambisius untuk menjadi pembangkit tenaga AI global, dengan chip AI sebagai pusatnya.

Kami sangat gembira dengan momentum Korea dalam bidang AI, dan hal ini akan meningkatkan ekosistem baru yang kami bangun untuk menggerakkan industri ini lebih dari sekadar GPU.

Ikuti TechRadar di Google Berita Dan tambahkan kami sebagai sumber pilihan untuk mendapatkan berita, ulasan, dan opini pakar kami di feed Anda. Pastikan untuk mengklik tombol Ikuti!

Dan tentu saja Anda juga bisa Ikuti TechRadar di TikTok untuk berita, review, unboxing dalam bentuk video, dan dapatkan update rutin dari kami Ada apa juga.